Fake-Videos & Fake-Audios: Wenn wir unseren Augen und Ohren nicht mehr trauen können

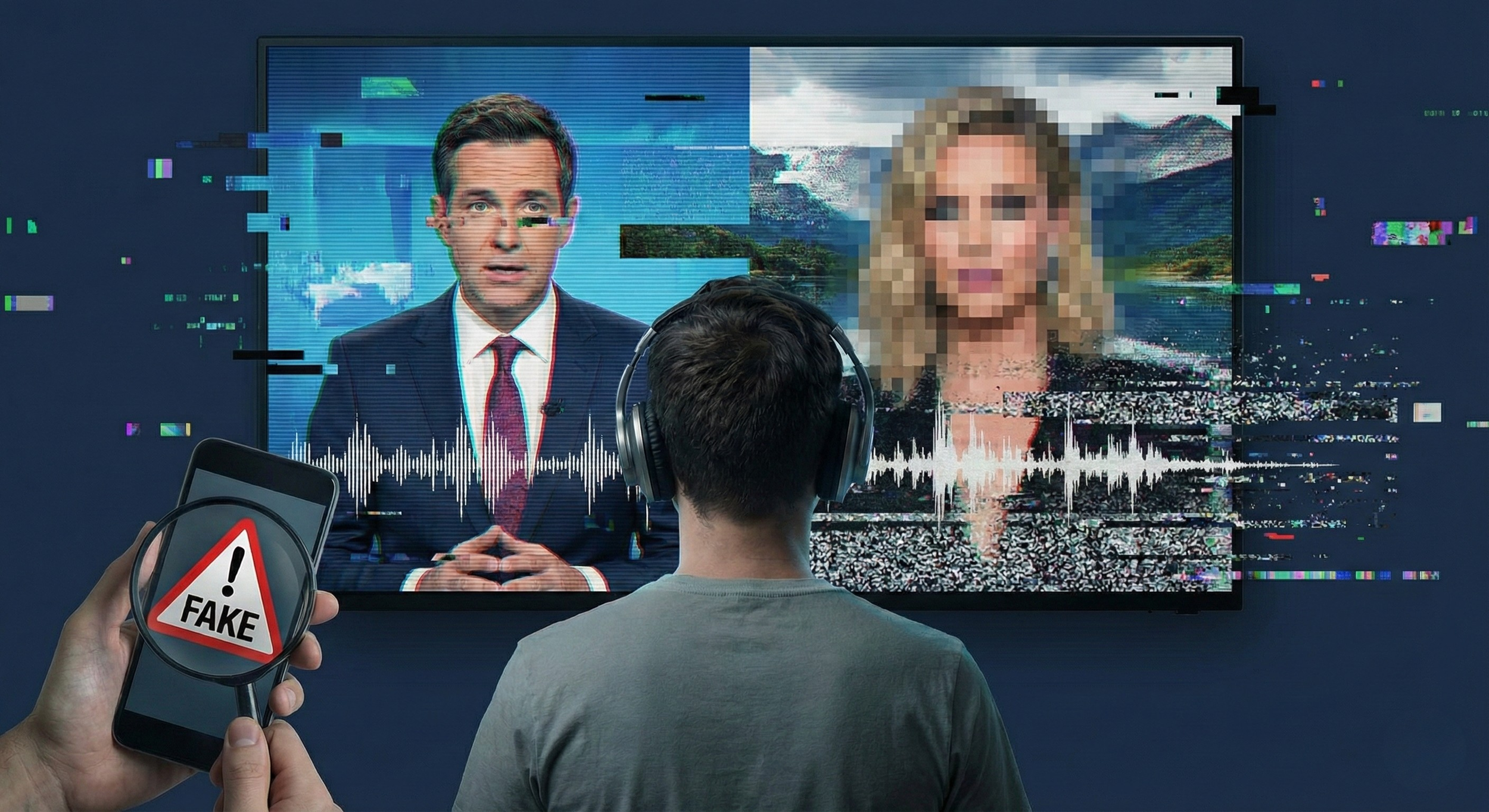

Es klingt wie die Stimme der eigenen Mutter. Es sieht aus wie ein echtes Video eines Klassenkameraden. Und genau das ist das Problem. Künstliche Intelligenz macht es heute möglich, täuschend echte Videos und Audios zu erzeugen, sogenannte Deepfakes. Was früher nach Science-Fiction klang, ist längst auf den Smartphones unserer Kinder angekommen. Für Eltern entsteht dadurch eine neue Dimension von Unsicherheit, denn nicht mehr alles, was wir sehen oder hören, ist real.

Bild generiert mit Hilfe von KI (Gemini, Google)

Was sind Fake-Videos und Fake-Audios eigentlich?

Fake-Videos und Fake-Audios werden mithilfe von KI generiert oder manipuliert. Gesichter können realistisch in Videos eingesetzt werden, Stimmen lassen sich innerhalb weniger Sekunden klonen. Dafür reicht oft schon ein kurzes Video von TikTok oder ein Sprachnachrichtenausschnitt aus WhatsApp. Die Technik ist inzwischen so gut, dass selbst Erwachsene Mühe haben, Fälschungen zu erkennen. Kinder und Jugendliche sind damit erst recht überfordert.

Warum Kinder und Jugendliche besonders gefährdet sind

Kinder bewegen sich selbstverständlich in digitalen Räumen. Sie vertrauen Bildern, Videos und Stimmen, weil sie damit aufgewachsen sind. Genau dieses Vertrauen wird ausgenutzt. Fake-Videos können genutzt werden, um Mitschüler bloßzustellen, Erwachsene unter Druck zu setzen oder Kinder gezielt zu manipulieren. Fake-Audios werden bereits für Betrugsmaschen genutzt, bei denen angeblich Eltern oder andere Bezugspersonen um Hilfe bitten. Für Kinder ist kaum erkennbar, dass hier etwas nicht stimmt. Hinzu kommt der soziale Druck. Wenn ein Video viral geht, zählt oft nicht, ob es echt ist. Entscheidend ist, dass es geteilt wird. Der Schaden entsteht sofort, selbst wenn später klar wird, dass alles gefälscht war. Für betroffene Kinder kann das massive Folgen haben, von Scham über Angst bis hin zu Rückzug und psychischer Belastung.

Fake-Content als Werkzeug für Erpressung und Manipulation

Besonders perfide ist der Einsatz von Deepfakes für Erpressung. Aus harmlosen Fotos werden sexualisierte Bilder oder Videos generiert. Täter drohen damit, diese Inhalte zu verbreiten, wenn kein Geld gezahlt oder weitere Bilder geschickt werden. Auch Fake-Audios spielen hier eine Rolle, etwa wenn angebliche Beweise oder Drohungen verschickt werden. Das alles passiert oft im Verborgenen, über Messenger oder soziale Netzwerke, und bleibt lange unentdeckt.

Warum Aufklärung wichtiger ist als Technik allein

Es gibt technische Ansätze zur Erkennung von Deepfakes, doch sie kommen meist zu spät oder sind unzuverlässig. Entscheidend ist deshalb Aufklärung. Kinder müssen lernen, dass Videos und Audios keine sicheren Beweise mehr sind. Eltern sollten erklären, dass Stimmen gefälscht sein können und dass man im Zweifel immer nachfragt oder einen zweiten Kanal nutzt. Ein Anruf bei der echten Person kann im Ernstfall entscheidend sein. Gleichzeitig braucht es eine Kultur des Hinsehens. Wenn Kinder wissen, dass sie mit Unsicherheit oder Angst zu ihren Eltern kommen können, sinkt die Macht der Täter. Schweigen ist der größte Verbündete von Fake-Content.

Was Eltern konkret tun können

Eltern müssen keine Technikexperten werden. Wichtiger ist es, regelmäßig über diese Themen zu sprechen. Fragen wie „Woher weißt du, dass dieses Video echt ist?“ oder „Was würdest du tun, wenn ich dich per Sprachnachricht um Geld bitte?“ helfen, ein kritisches Bewusstsein zu entwickeln. Klare Absprachen, etwa niemals auf Drucknachrichten zu reagieren, ohne Rücksprache zu halten, geben Kindern Sicherheit. Fake-Videos und Fake-Audios sind keine Zukunftsgefahr, sie sind längst Realität. Je früher wir das akzeptieren und offen darüber sprechen, desto besser können wir unsere Kinder schützen. Vertrauen bleibt wichtig, aber es braucht heute mehr denn je einen kritischen Blick und ein offenes Ohr.

Passend zum Thema: Der Clip “Nachricht von Ella”

Weiterführende Quellen und Studien

Die Risiken durch Fake Videos und Fake Audios sind gut dokumentiert. Die Europol warnt seit Jahren vor dem Einsatz von KI-basierten Deepfakes für Betrug, Erpressung und gezielte Manipulation, insbesondere im familiären Umfeld und bei Minderjährigen: https://www.europol.europa.eu/publications-events/publications/facing-reality-law-enforcement-and-challenge-of-deepfakes

Auch das Bundesamt für Sicherheit in der Informationstechnik beschreibt Voice Cloning und manipulierte Videos als wachsende Bedrohung für Privatpersonen und Familien, mit konkreten Hinweisen zu Betrugsfällen über angebliche Anrufe von Angehörigen: https://www.bsi.bund.de/DE/Themen/Verbraucherinnen-und-Verbraucher/Cyber-Sicherheitslage/Fake-Anrufe-und-Deepfakes/fake-anrufe-und-deepfakes_node.html

Die Federal Bureau of Investigation hat 2023 eine offizielle Warnung veröffentlicht, dass KI-generierte Stimmen gezielt genutzt werden, um Kinder und Eltern unter Druck zu setzen und Geld zu erpressen: https://www.ic3.gov/Media/Y2023/PSA230403

Eine umfassende wissenschaftliche Einordnung liefert das MIT Media Lab, das zeigt, wie schwer selbst für Erwachsene Deepfakes zu erkennen sind und warum soziale Kontexte entscheidender sind als technische Erkennungsmerkmale: https://www.media.mit.edu/projects/detect-fakes/overview/

Für Eltern besonders relevant ist zudem die Analyse der NGO Internet Watch Foundation, die dokumentiert, wie KI-generierte sexualisierte Inhalte von Kindern rasant zunehmen und für Erpressung missbraucht werden: https://www.iwf.org.uk/resources/ai-generated-child-sexual-abuse-material/